产品介绍

NVIDIA® Quantum-2 InfiniBand 平台的关键组件,NVIDIA ConnectX®-7 智能网卡 (HCA)具备出色的网络性能,能够应对全球极具挑战性的问题。

ConnectX-7 InfiniBand 网卡支持超低延迟、400 Gb/s 吞吐量和创新的NVIDIA 网络计算引擎,能够为高性能计算(HPC)、人工智能(AI)和超大规模云数据中心提供所需的加速能力、可扩展性和功能丰富的技术。 高性能计算和人工智能已将超级计算机作为主要数据处理引擎,广泛用于商业用途, 助力科学研究、科学发现和产品开发。这些系统能够执行复杂的模拟,并开启由软件编写软件的AI 新时代。

NVIDIA InfiniBand 网络是这些平台的引擎,可提供突破性的表现。 ConnectX-7 的智能网络计算加速引擎包括集合加速、MPI Tag Matching 和 MPI_Alltoall 引擎。这些性能优势以及前后向兼容性的标准保证,能够确保计算和数据密集型应用程序的出色性能和可扩展性,帮助用户保护其数据中心投资。

产品描述

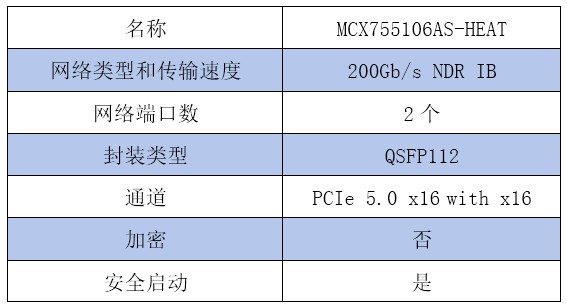

NVIDIA ConnectX-7 HHHL Adapter Card, 200GbE (default mode) / NDR200 IB, Dual-port QSFP112, PCIe 5.0 x16 with x16 PCIe extension option, Crypto Disabled, Secure Boot Enabled, Tall bracket

NVIDIA CONNECTX-7

InfiniBand 网络计算网卡

利用网络计算来加速数据驱动的科学计算

作为 NVIDIA® Quantum-2 InfiniBand 平台的关键组件,NVIDIA ConnectX®-7 智能网卡 (HCA)具备出色的网络性能,能够应对全球极具挑战性的问题。ConnectX-7 InfiniBand 网卡支持超低延迟、400 Gb/s 吞吐量和创新的 NVIDIA 网络计算引擎,能够为高性能 计算(HPC)、人工智能(AI)和超大规模云数据中心提供所需的加速能力、可扩展性和 功能丰富的技术。

高性能计算和人工智能已将超级计算机作为主要数据处理引擎,广泛用于商业用途, 助力科学研究、科学发现和产品开发。这些系统能够执行复杂的模拟,并开启由软件 编写软件的 AI 新时代。NVIDIA InfiniBand 网络是这些平台的引擎,可提供突破性的 表现。

ConnectX-7 的智能网络计算加速引擎包括集合加速、MPI Tag Matching 和 MPI_Alltoall 引擎。这些性能优势以及前后向兼容性的标准保证,能够确保计算和数据密集型应用 程序的出色性能和可扩展性,帮助用户保护其数据中心投资。

产品组合

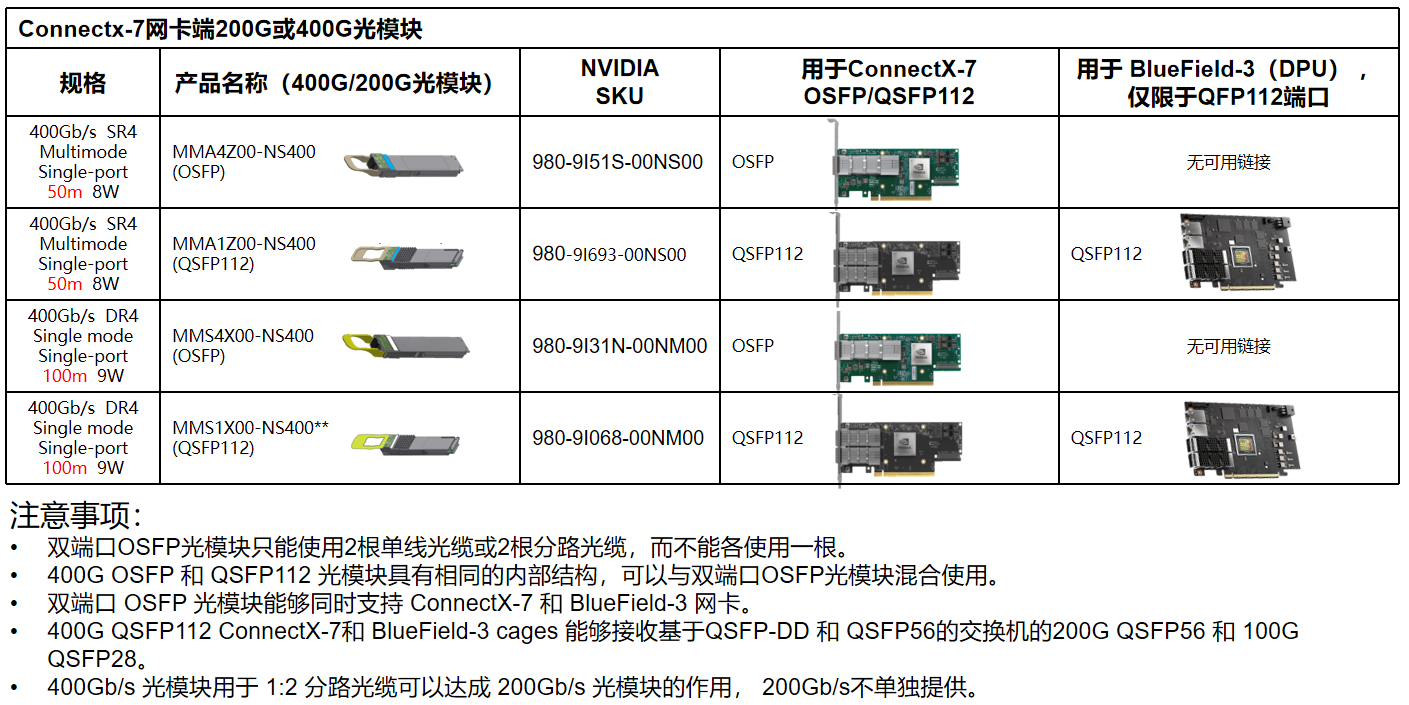

> 单端口或双端口,每端口 400Gb/s 或 200Gb/s,端口采用 OSFP 连接器

> 双端口 200Gb/s,采用 QSFP 连接器

> PCIe 标卡半高半长(HHHL)外形规格,具有 NVIDIA Socket Direct™ 选项

> 开放计算项目 3.0 (OCP3.0)全高小卡(TSFF)和小卡(SFF)

> 独立 ConnectX-7 专用集成电路(ASIC),支持 PCIe 交换机功能

特性*

InfiniBand

> 符合 InfiniBand 行业协会(IBTA) 规范 1.5

> 多达四个端口 > 远程直接内存访问(RDMA), 发送 / 接收语义

> 基于硬件的拥塞控制

> 原子操作

> 1600 万个输入 / 输出(IO)通道

> 最大传输单位(MTU)支持 256B 到 4KB, 消息长度最大支持 2GB

> 8 个虚拟通道(VL) + VL15

增强型网络

> 基于硬件的可靠传输

> 扩展的可靠连接(XRC)传输

> 动态连接传输(DCT)

> GPUDirect® RDMA

> GPUDirect Storage

> 乱序 RDMA 支持动态路由

> 增强型原子操作

> 高级内存映射支持,允许用户模式注册 和重新映射内存(UMR)

> 按需分页(ODP),包括免注册 RDMA 内存访问

> 增强型拥塞控制

> Burst buffer offload

网络计算

> 集合运算卸载

> 向量集合操作卸载

> MPI Tag Matching

> MPI_Alltoall 卸载

> Rendezvous

> 网络内存 协议卸载

基于硬件的 IO 虚拟化

> 单根 IO 虚拟化(SR-IOV)

存储卸载

> 块级加密 : XTS-AES 256/512 位密钥

> 目标服务器的 NVMe over Fabrics (NVMe-oF)卸载

>线速 T10 数据完整性域(DIF)签名移交 操作,用于入口和出口流量

> 存储协议 :SRP、iSER、NFS RDMA、 SMB Direct、NVMe-oF

HPC 计算软件库

> NVIDIA HPC-X® 和 UCX® 、UCC、 NCCL、

OpenMPI、MVAPICH、MPICH、

OpenSHMEM、PGAS 以及各种商用 软件包

管理和控制

> NC-SI、MCTP over SMBus 和 MCTP over PCIe

> 用于监视和控制的 PLDM DSP0248

> 用于固件更新的 PLDM DSP0267

> 用于 Redfish Device Enablement 的 PLDM DSP0218

> 用于 FRU DSP0257 的 PLDM

> SPDM DSP0274

> 通用型 IO 引脚

> 串行外设接口(SPI)至闪存

> JTAG IEEE 1149.1 和 IEEE 1149.6

远程启动

> 通过 InfiniBand 远程启动

> 通过 iSCSI 远程启动

> 统一可扩展固件接口(UEFI)

> 预引导执行环境(PXE)

安全性

> 通过硬件信任根进行安全启动

> 安全固件更新

> 闪存加密

高级时钟和同步

> 高级 PTP

> IEEE 1588v2(任何尺寸)

> 线速硬件时间戳(UTC 格式)

> 可配置 PPS 输入和 PPS 输出

> 时间触发的调度

> 基于 PTP 的流量整形(Packet pacing)

> 时间敏感网络(TSN)

兼容性

PCI Express 接口

> 兼容 PCIe 5.0,32 通道

> 支持 PCIe x1、x2、x4、x8 和 x16 配置

> NVIDIA Multi-Host™ 支持连接多达 8 个 主机

> PCIe Atomic

> 事务层数据包(TLP)处理提示(TPH)

> PCIe 交换机下行端口控制(DPC)

> 高级错误报告(AER)

> 用于对等安全通信的访问控制服务 (ACS)

> 进程地址空间 ID (PASID)

> 地址翻译服务(ATS)

> 支持 MSI/MSI-X 机制

> 支持 SR-IOV

操作系统 / 发行版 *

> 适用于主要操作系统的内置驱动程序 :

> Linux :RHEL、Ubuntu

> Windows > 虚拟化和容器

> VMware ESXi (SR-IOV)

> Kubernetes

> OpenFabrics 企业发行版(OFED)

> OpenFabrics Windows Distribution(WinOF-2)